Avec l’explosion des données numériques, les entreprises se tournent vers les architectures Big Data pour manipuler et analyser des volumes massifs de données. Trois architectures dominent le paysage : Batch Processing, Stream Processing et Lambda Architecture. Chacune offre des avantages distincts et répond à des besoins spécifiques en matière de traitement des données.

Batch Processing

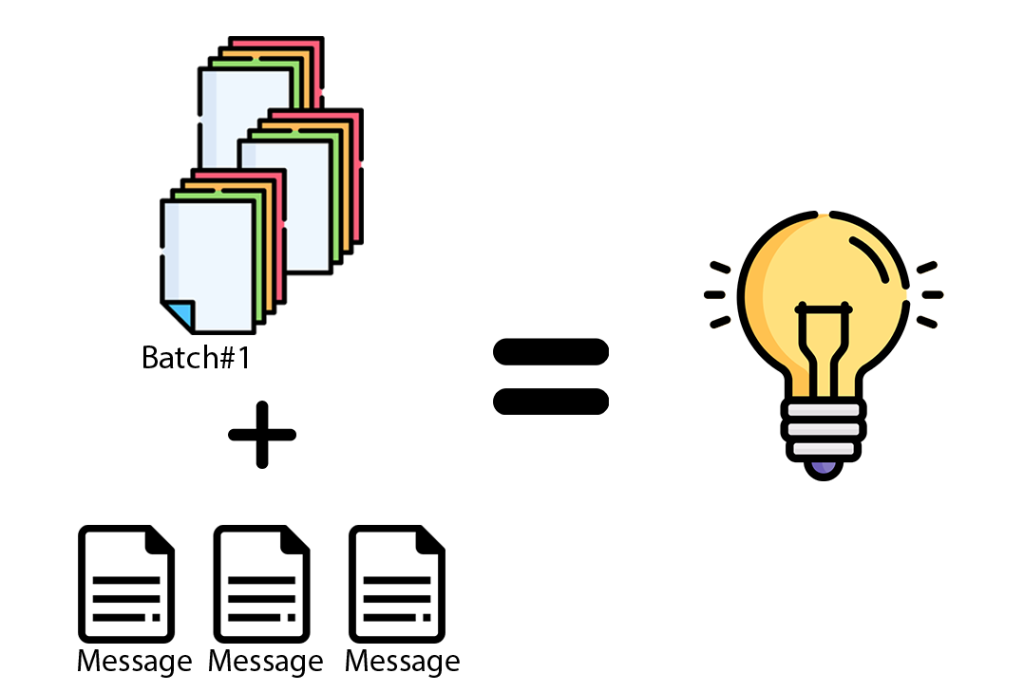

L’architecture de Batch Processing est largement utilisée pour le traitement de volumes élevés de données de manière périodique. Dans cette approche, les données sont collectées sur une période donnée, puis traitées en un seul lot (ou “batch”).

Hadoop est un exemple emblématique de cette architecture, avec son système de fichiers distribué HDFS et son moteur de traitement MapReduce.

Dans HDFS, les données sont stockées sur plusieurs machines pour une tolérance aux pannes et une répartition du traitement, tandis que MapReduce est un modèle de traitement parallèle, où la tâche est divisée (map) et traitée en parallèle sur différents nœuds du cluster, puis les résultats sont agrégés (reduce).

Cependant, le Batch Processing présente une latence inhérente. Les résultats ne sont disponibles qu’après le traitement complet du lot, ce qui peut prendre des heures voire des jours selon la taille des données. Cette architecture convient donc mieux aux analyses non interactives où la rapidité n’est pas cruciale.

Stream Processing

Face à l’exigence d’analyses en temps réel, l’architecture de Stream Processing gagne en popularité. Ici, les données sont traitées dès leur arrivée, ce qui permet des analyses en temps réel et des décisions rapides. Des outils comme Apache Kafka et Apache Storm sont fréquemment utilisés dans cette architecture.

Kafka agit comme un tampon pour les flux de données entrants, offrant une grande durabilité grâce à la réplication des données sur plusieurs nœuds. Storm, de son côté, consomme ces flux de données et effectue un traitement en temps réel, avec un modèle de topologie où les données sont passées à travers un graphe de nœuds de traitement, permettant un traitement parallèle et distribué.

Néanmoins, le Stream Processing nécessite une infrastructure robuste et des compétences techniques avancées pour gérer le flux continu de données. De plus, il n’est pas toujours approprié pour des analyses complexes qui nécessitent l’observation de l’ensemble des données, comme l’analyse de tendances sur une longue période.

Lambda Architecture

Pour combler les lacunes des deux architectures précédentes, la Lambda Architecture a été proposée. Cette architecture combine le Batch et le Stream Processing pour exploiter les avantages de chacune. Elle utilise une couche de batch pour le traitement à grande échelle des données historiques et une couche de flux pour le traitement en temps réel des données récentes. Les résultats sont ensuite fusionnés pour fournir une vue complète et précise.

La Lambda Architecture se caractérise par l’existence de trois couches principales. La couche Batch (ou couche de traitement par lots), la couche Speed (ou couche de traitement en temps réel), et la couche Serving (ou couche de service) qui sert les résultats. La couche Batch calcule des vues en lots à partirdes données historiques, alors que la couche Speed compense le retard inhérent au traitement par lots en fournissant des vues en temps réel sur les données récentes. Les vues générées par ces deux couches sont fusionnées dans la couche Serving pour fournir une vue unifiée des données.

Cependant, la mise en œuvre de la Lambda Architecture peut être complexe, car elle nécessite de maintenir deux pipelines de données distincts. Néanmoins, elle offre une solution flexible et performante pour les situations où l’analyse en temps réel et l’analyse à grande échelle sont toutes deux nécessaires.

En conclusion, le choix de l’architecture dépend des besoins spécifiques de chaque projet. L’architecture Batch est idéale pour les analyses lourdes et non urgentes, le Stream Processing est adapté pour les analyses en temps réel, tandis que la Lambda Architecture offre un équilibre entre les deux. À mesure que le paysage du Big Data évolue, de nouvelles architectures continueront à émerger pour répondre aux défis du traitement des données à grande échelle.